小米发布新模子MiMo-V2-Flash:忘形 DeepSeek-V3.2

发布日期:2025-12-24 11:27 点击次数:143

DoNews12月17日音讯,据APPSO报谈,刚刚,小米精采发布并开源新模子 MiMo-V2-Flash。MiMo-V2-Flash 总参数 3090 亿,活跃参数 150 亿,接纳民众搀和架构 (MoE),性能还能和 DeepSeek-V3.2、Kimi-K2 这些头部开源模子掰掰手腕。

此外,MiMo-V2-Flash 接纳 MIT 开源公约,基础版权重也如故在 Hugging Face 上发布。撤回「开源」这一标签,新模子实在的杀手锏在于架构想象上的激进转换,把推理速率拉到了 150 tokens/秒,老本压到了每百万 token 输入 0.1 好意思元、输出 0.3 好意思元,主打一个超绝性价比。

左证官方体验页面信息,MiMo-V2-Flash 还复古深度念念考和联网搜索功能,既能对话聊天,也能在需要及时数据、最新动态或贵府查对的场景里派上用场。

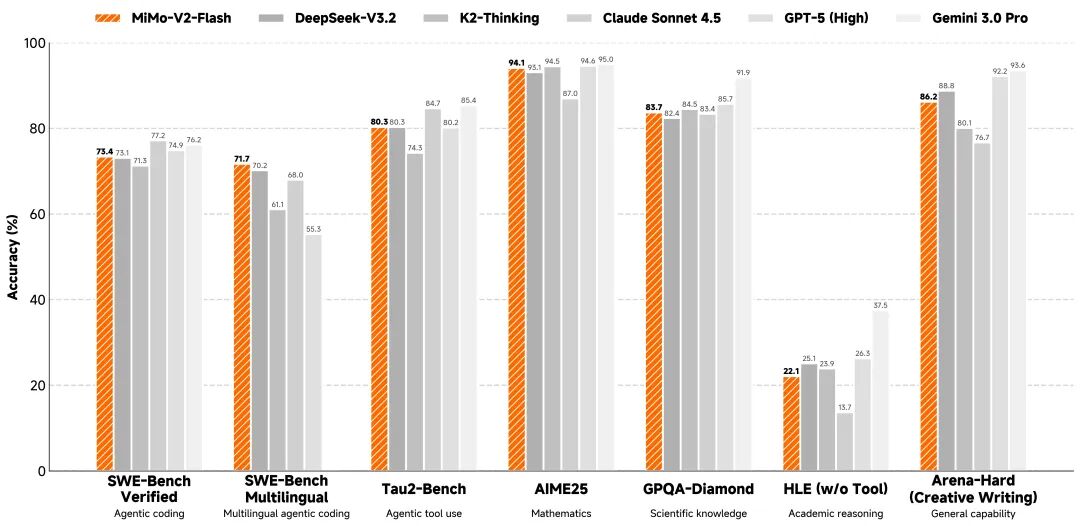

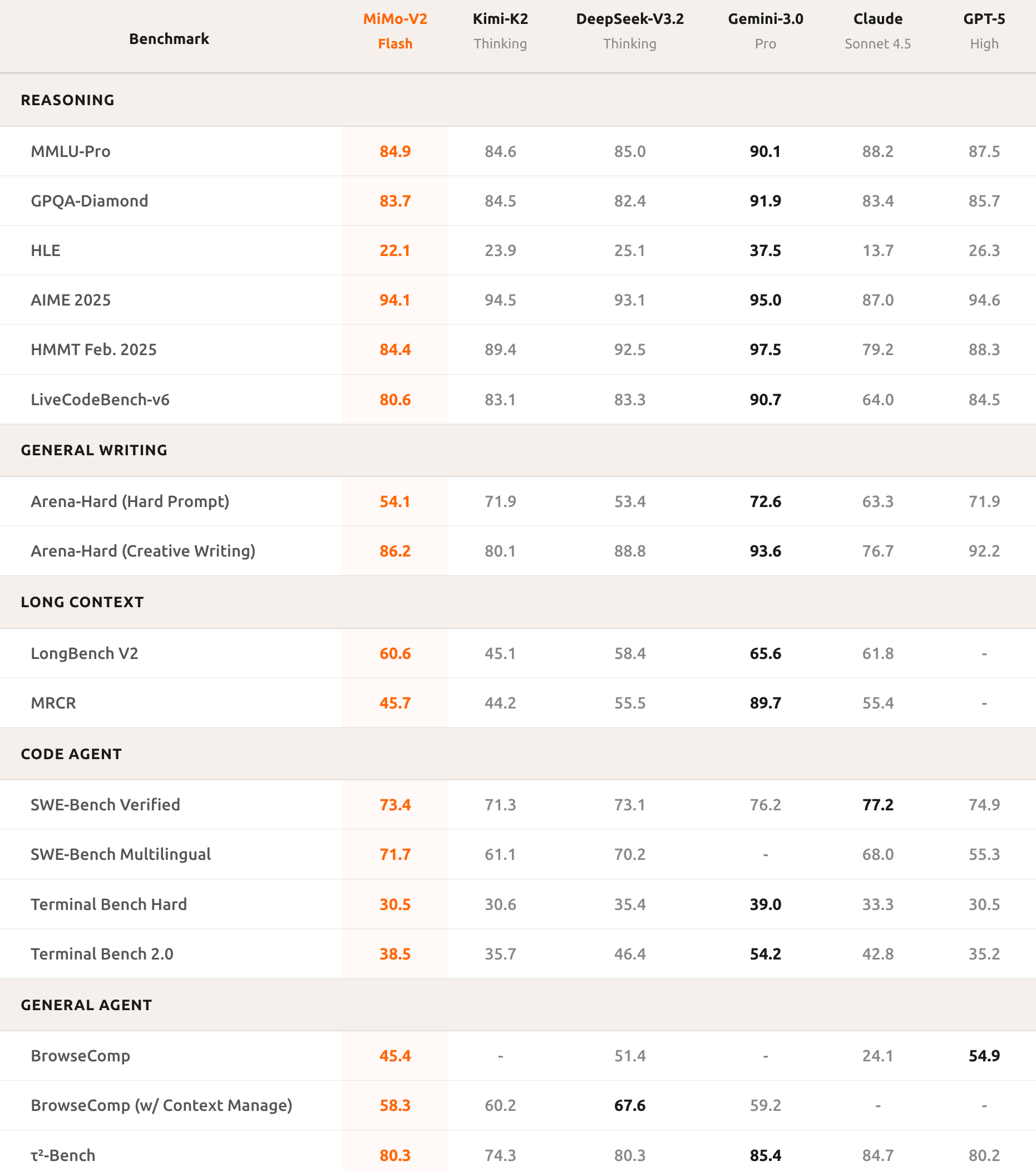

基准测试得益显现,AIME 2025 数学竞赛和 GPQA-Diamond 科学学问测试中,MiMo-V2-Flash 齐排在开源模子前两名。编程才调更是亮眼,SWE-bench Verified 得分 73.4%,杰出通盘开源模子,直逼 GPT-5-High。而这个测试是让 AI 去修简直天下的软件 bug,73.4% 的告捷率也意味着它能惩办大部分内容编程问题。

在多言语编程基准测试 SWE-Bench Multilingual 里,MiMo-V2-Flash 的解决率为 71.7%。转看智能体任务,MiMo-V2-Flash 在τ²-Bench 分类得分中,通讯类 95.3 分,零卖类 79.5 分,航空类 66.0 分,BrowseComp 搜索代理得分 45.4,启用险阻文料理后平直飙到 58.3。

这些数据讲明,MiMo-V2-Flash 不仅会写代码,还能实在知晓复杂任务逻辑,实施多轮智能体交互。

更紧要的是,写稿质地也接近顶级闭源模子,这意味着 MiMo-V2-Flash 不仅仅个器用,还能当个靠谱的平素助手。

MiMo-V2-Flash 在保握长诗人性能的同期,还裁减了老本,究其原因,离不开两项中枢手艺转换。

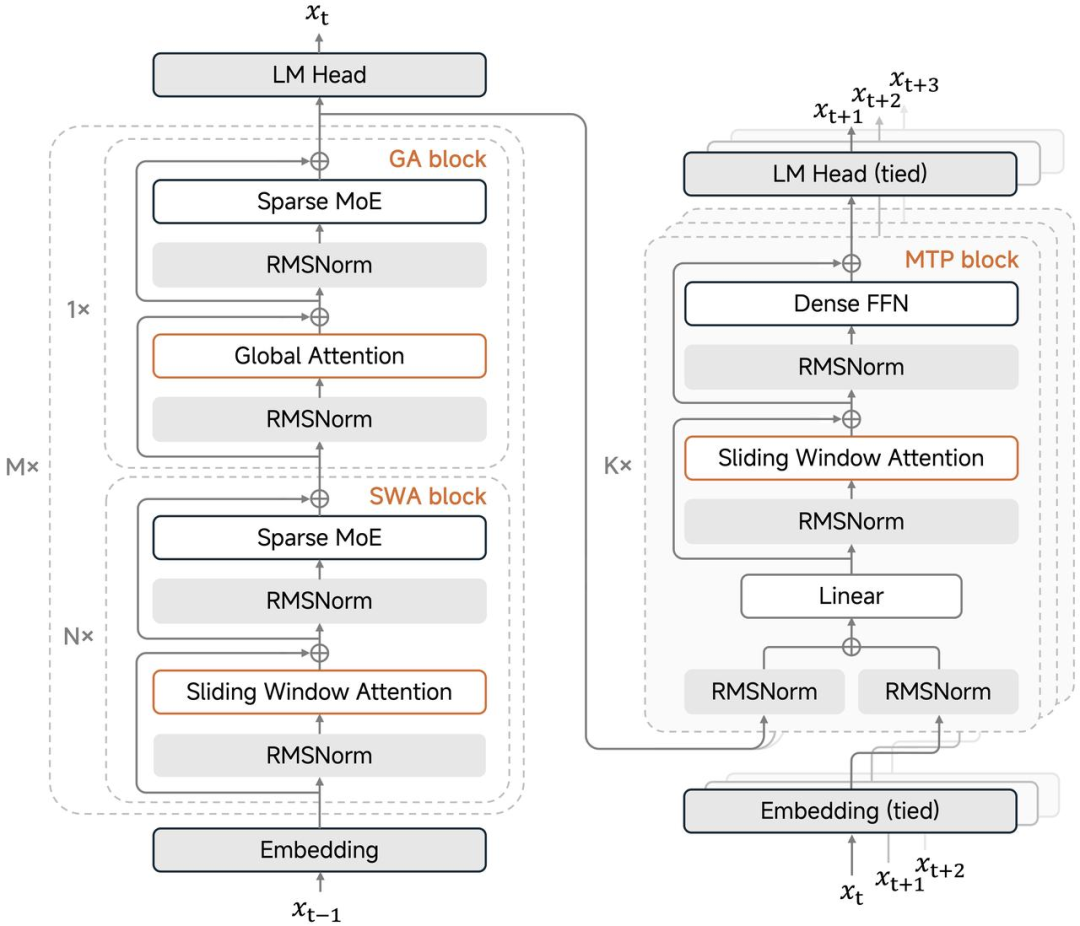

搀和滑动窗口细心力机制:传统大模子处理长文本时,全局细心力机制会导致想象量二次爆炸,存储中间竣事的 KV 缓存也随着飙升。

小米此次接纳了 5 比 1 的激进比例,5 层滑动窗口细心力搭配 1 层全局细心力轮换使用,滑动窗口只看 128 个 token。

这种想象让 KV 缓存存储量平直减少了近 6 倍,但长文本才调却没打扣头,最长复古 256k 险阻文窗口。

且模子即使在这样激进的窗口竖立下,照样能稳住长诗人性能。

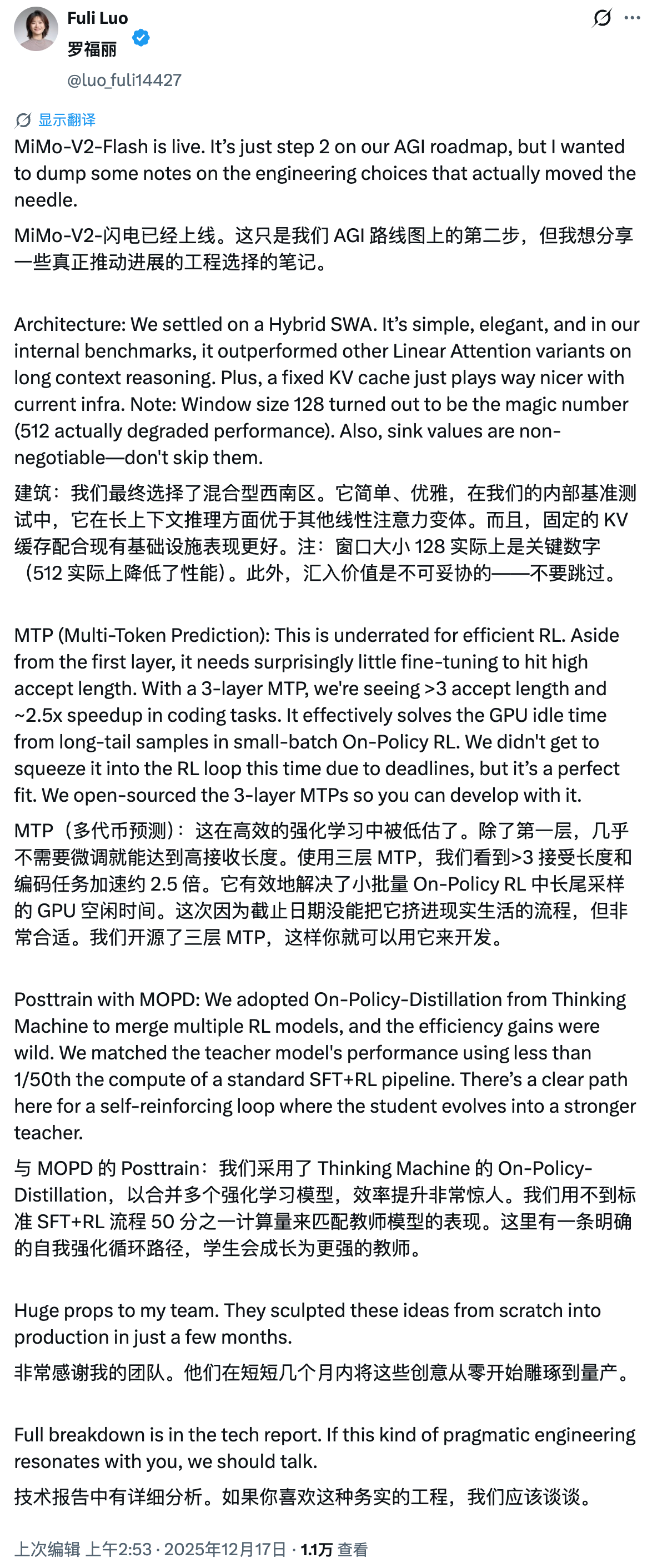

对此,罗福莉在应对平台上稀零指出一个反直观的发现:窗口大小 128 是「最好甜点值」。实考据明,盲目扩大窗口(如增至 512)反而会导致性能下跌。同期她强调,在实施该机制时,sink values 是保管性能的要道,毫不能不详。

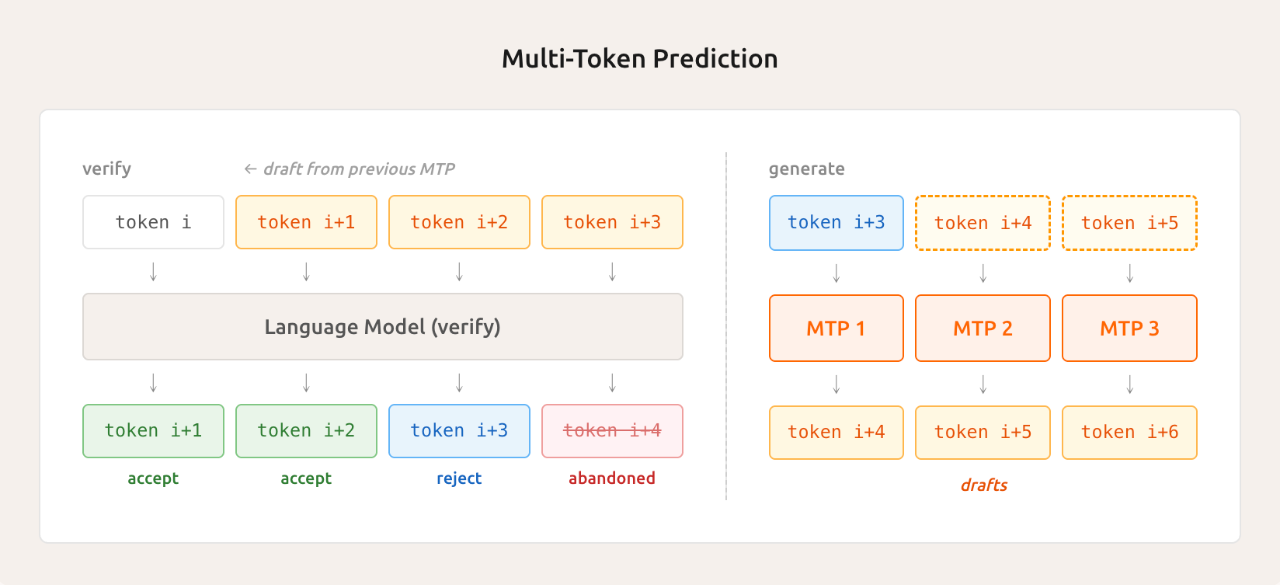

另一个黑科技是轻量级多 Token 瞻望 (MTP)。

传统模子生成文本时一次只可吐一个 token,就像打字员一个字一个字敲。MiMo-V2-Flash 通过原生集成的 MTP 模块,能并行瞻望多个 token,一次性猜出接下来好几个 token。

实测平均能收受 2.8 到 3.6 个 token,推理速率平直升迁 2 到 2.6 倍,不仅在推理时管用,教师阶段也能加快采样,减少 GPU 空转,属于一石两鸟。

罗福莉提到,在三层 MTP 竖立下,他们不雅察到平均收受长度跳跃 3,编码任务速率升迁约 2.5 倍。它灵验解决了小批量 On-Policy 强化学习中「长尾样本」带来的 GPU 舒畅时刻枉然问题。

啥叫长尾样本?便是那些稀零难、稀零慢的任务,拖着其他任务沿路等,GPU 就在那干横目。MTP 把这个问题给解了,极大提高了效果。

不外罗福莉也坦诚,此次因为时刻要紧没能把 MTP 齐全集成进 RL 教师轮回,但它与该历程高度契合。小米如故把三层 MTP 开源了,便捷民众在我方的阵势中使用与开拓。

算力只用 1/50,性能若何不打折?

预教师阶段,新模子使用 FP8 搀和精度,在 27 万亿 token 数据上完成教师,原生复古 32k 序列长度。

FP8 搀和精度是一种压缩数值暗示的手艺,能在保握精度的同期减少显存占用和加快教师。这种教师方式在业界并不常见,需要对底层框架进行深度优化。

而在后教师阶段,小米整了个大活,建议了多教师在线政策蒸馏 (MOPD)。

传统的监督微调加强化学习管线,不仅教师不雄厚,算力消费还贼高。MOPD 的念念路是让学生模子在我方的政策溜达上采样,然后由多个民众教师在每个 token 位置提供密集的奖励信号。

MOPD Architecture Diagram

豪迈点说便是,学生模子我方写功课,淳厚在每个字上齐给评分,无谓等写齐全篇才打分。这样一来,学生模子能快速从教师那处学到精髓,况兼教师过程雄厚得多。

最夸张的是效果升迁,MOPD 只需要传统身手 1/50 的算力,就能让学生模子达到教师性能峰值。这意味着小米能用更少的资源,更快地迭代模子。

况兼 MOPD 复古天真接入新教师,学生模子成长后还能反过来当教师,酿成「教与学」的闭环自我进化。今天的学生,未来的淳厚,后天又能教出更强的学生,套娃玩法属实有点东西。

用罗福莉的话来说,他们鉴戒 Thinking Machine 的 On-Policy Distillation 身手,将多个强化学习模子进行会通,竣事带来了惊东谈主的效果升迁。这为构建一个自我强化轮回系统奠定了基础,学生模子不错渐渐进化,最终成为更强的教师模子。

On-Policy Distillation - Thinking Machines Lab

在智能体强化学习膨大上,小米 MiMo-V2-Flash 商讨团队基于简直 GitHub issue 构建了跳跃 10 万个可考据任务,自动化活水线跑在 Kubernetes 集群上,并发能开 10000 多个 Pod,环境部署告捷率 70%。

针对网页开拓任务,还挑升搞了个多模态考据器,通过录制视频而非静态截图来考据代码实施竣事,平直减少视觉幻觉,确保功能正确。

关于开拓者而言,MiMo-V2-Flash 能与 Claude Code、Cursor、Cline 等主流开拓环境无缝息争,256k 的超长险阻文窗口复古数百轮智能体交互与器用调用。

256k 是什么见解? 好像终点于一册中等篇幅的演义,或者几十页手艺文档。这意味着开拓者不错把 MiMo-V2-Flash 平直融入现存使命流,不需要颠倒适配,拿来就用。

小米还把通盘推理代码孝敬给了 SGLang,并在 LMSYS 博客共享了推理优化培育。

手艺讲述公开了齐全模子细节,模子权重 (包括 MiMo-V2-Flash-Base) 在 Hugging Face 上以 MIT 许可公约发布。这种全面开源的格调,在国内大厂里属实罕有。

现在 MiMo-V2-Flash 如故在 API Platform 限时免费灵通,开拓者不错平直上手体验。